Dans cet article, nous allons parler du fichier robots.txt et de son importance dans une stratégie SEO. Vous voulez savoir ce que c’est et comment l’utiliser ? Suivez le guide !

Partagez cet article

Qu’est-ce qu’un fichier robots.txt ?

Robots.txt est un fichier texte que les Webmasters créent, et qui signale aux robots (crawler) des moteurs de recherche à quelles URL ils peuvent accéder sur votre site web. En effet, les moteurs de recherche « crawl » (parcourent) le web, et à chaque page, ils suivent les liens présents sur celle-ci, ce qui leur permet de passer d’un site à l’autre. Mais avant de parcourir une page web, les robots des moteurs de recherche, comme Google, vont lire le fichier robots.txt afin de savoir s’ils ont l’autorisation de la visiter.

Où se trouve le fichier robots.txt ?

Le fichier robots.txt de votre site, doit se trouver à la racine de votre site web.

Par exemple, pour le site de Web Hors Piste, https://www.webhorspiste.com/ il se trouve ici https://www.webhorspiste.com/robots.txt . Il est nécessaire que votre fichier robots.txt soit nommé robots.txt et pas autrement. Faites attention, il est sensible à la casse, ne placez donc pas de majuscules dans son nom, donc pas de Robots.txt, robots.TXT ou quoi que ce soit d’autre. Si un robot d’exploration ne trouve pas de fichier robots.txt à la racine de votre site, alors celui-ci considérera qu’il en est dépourvu et procédera à l’exploration du site.

Les avantages et inconvénients du fichier robots.txt

Avantages :

Les spiders (robots d’exploration) on une “allocation” de temps ou de ressource prédéfinie pour chaque site web, c’est ce que l’on appelle le budget de crawl.

Si votre site a des problèmes de budget de crawl, pour éviter de le gaspiller sur des pages non importantes (comme la page login, remerciements, ou panier d’un e-commerce ou d’autres), on peut indiquer aux moteurs de recherche de ne pas explorer ces pages.

Il peut aussi empêcher l’exploration, l’indexation ou l’apparition des pages de résultats de recherche interne de votre site dans les résultats de recherche.

Il peut aussi éviter que du contenu dupliqué ne soit détecté par Google.

Inconvénients :

Le fichier robots.txt ne peut pas empêcher l’indexation, en effet Google peut indexer une page sans l’avoir crawlé. Si un nombre important de liens pointent vers cette URL, il l’inclura dans l’index, il ignorera juste le contenu de cette page. Il placera un titre en fonction des ancres et pour la meta description il affichera ceci :

Si vous voulez bloquer l’indexation d’une page, préférez plutôt l’utilisation de la balise méta : robots et retirer disallow, car sinon Google ne pourra pas savoir que la dite page est en noindex.

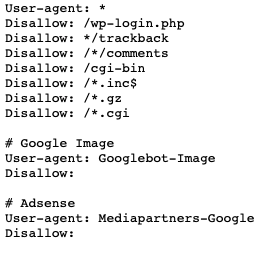

Pour bloquer tous les robots d’exploration :

<meta name= »robots » content= »noindex »>

Pour bloquer Googlebot :

<meta name= »googlebot » content= »noindex »>

Ressources sur le sujet :

Présentation du fichier robots.txt et guide | Google Search Central | Documentation

Google : crawl et indexation malgré interdiction via fichier robots.txt

Autre inconvénient, si une page est en disallow mais qu’elle reçoit des liens, Google ne pourra pas répartir le jus de ces liens parmi les liens présent sur la page vu qu’il ne peut pas l’explorer, ce serait donc une perte sèche de jus.

C’est quoi un user agent ou agent utilisateur ?

Un agent utilisateur est tout logiciel, agissant au nom d’un utilisateur, qui « récupère, restitue et facilite l’interaction de l’utilisateur final avec le contenu Web ».

Chaque périphérique qui navigue sur le web se voit attribué un agent utilisateur, que ce soit des robots ou des humains. Pour les humains par exemple, on pourra voir le navigateur utilisé ainsi que le système d’exploitation. Chaque fois que vous vous connectez à un site Web, votre navigateur envoie son User-Agent à ce site Web.

Grace au fichier robots.txt, les webmasters peuvent donner des consignes spécifiques aux bots en y plaçant des instructions pour chaque user agent. Par exemple, vous voulez

Dans un fichier robots.txt, les administrateurs de sites web peuvent fournir des instructions caractéristiques pour des bots spécifiques en écrivant différentes instructions pour les agents utilisateurs de bots.

La syntaxe du fichier robots.txt

Le fichier robots.txt comprend 5 termes que vous rencontrerez couramment :

disallow : C’est la commande pour empêcher l’exploration d’une URL choisie.

allow : cette commande indique à Googlebot (et à lui seul) qu’il peut avoir accès à une page ou un sous dossier même si la page mère ou le dossier parent est interdit.

user-agent : Il s’agit là de choisir à quel robot d’exploration vous adressez vos instructions.

crawl-delay : Indique aux robots d’exploration combien de seconde ils doivent attendre avant d’explorer le contenu d’une page. (Googlebot ignore cette indication)

sitemap : Il sert à indiquer l’emplacement du/des sitemap.xml aux crawlers.

Ressource : Comment Google interprète la spécification robots.txt | Documentation

Comment Web Hors Piste peut m’aider

L’équipe Web Hors Piste vous accompagne pour définir et optimiser la stratégie digitale de votre entreprise.

Si vous avez des questions, n’hésitez pas à nous contacter et demander l’avis d’un expert.

Partagez cet article

Nos Derniers Articles

Découvrez dans notre blog SEO les dernières actualités de Référencement Naturel, les mises à jour de l’algorithme Google et des bonnes pratiques pour l’optimisation SEO de votre site.

Top 10 des meilleurs outils de SEO

En 2020, 93% des expériences digitales ont débuté sur un moteur de recherche. Découvrez les meilleurs outils SEO pour booster votre visibilité sur les moteurs de recherche.

Comment fonctionne un moteur de recherche ?

Comment Google sait quels résultats vous proposer dans les résultats de recherche ? Le processus commence avant même que vous ayez saisi votre requête…

Analyse sémantique en SEO : les meilleurs outils

Pour nous autre, humain, comprendre le sens d’un texte est quelque chose de plutôt facile, nous reconnaissons les mots selon le contexte utilisé. Cependant, pour les machines, la chose est bien moins évidente.

Nous partageons avec nos clients les dernières nouveautés dans le digital. Si cela vous intéresse, profitez-en